Nous allons voir dans ce cours des techniques d'optimisation.

Optimiser une solution, c'est la rendre plus rapide car plus efficace. Elle vise à utiliser des raccourcis ou à éviter des opérations inutiles ou redondantes.

Dans le cas de la

récursivité, elle permet de simplifier le code et d'éviter certains bugs

(effets de bords).

Optimiser conduit ainsi souvent à améliorer la

complexité d'un algorithme et donc sa rapidité d'exécution.

En première,

vous avez vu le cas de l'algorithme de recherche séquentielle de

complexité linéaire 𝑂(𝑛) et celui de la recherche dichotomique, de

complexité logarithmique 𝑂(log(𝑛)), qui était plus efficace.

Voir l'article sur l'Analyse de la complexité algorithmique (Wikipédia)

Récursivité

Un algorithme récursif est un algorithme

qui fait appel à lui-même.

Ainsi, une fonction 𝑓 est récursive lorsque la déclaration de cette fonction 𝑓 contient un appel à cette fonction 𝑓.

Nous allons voir qu'il existe différents types de récursivité : simple, double/multiple, imbriquée et mutuelle/croisée.

Récursivité simple

1.1.1. Exemple avec la fonction factorielle

En mathématiques, la factorielle d'un entier 𝑛∊ℕ, notée fact(𝑛) ou 𝑛!, est définie par : fact(𝑛) = 1×2×3×...×(𝑛-1)×𝑛.

Ainsi

fact(𝑛) = 𝑛×fact(𝑛-1)

On peut ainsi donner une définition

récursive de la factorielle :

Pour programmer récursivement, il faut être capable de découper le problème en sous-problèmes plus simples. À partir de là, il faut distinguer deux cas :

le cas récursif qui permet de passer du problème au sous-problème et qui empile les appels récursifs et le cas trivial (ou condition d'arrêt) qui permet d'arrêter l'empilement et de commencer à faire remonter les résultats.

Dans l'exemple de la fonction factorielle :

- Le cas où 𝑛 = 0

assure l'arrêt de l'empilement des appels récursifs et la remontée

des résultats.

Ce cas est appelée le cas de base ou cas trivial. - Le cas où 𝑛 > 0 est appelée le cas récursif ou cas non-trivial. C'est là que l'on passe du problème fact(𝑛) à un sous-problème plus simple fact(𝑛-1). Les appels récursifs successifs permettent ainsi d'atteindre le cas trivial.

fact(3)Cliquer pour stopper l'animation.

(Image cliquable)

1.1.2. Cas de base/cas triviaux multiples - Exemple avec la fonction factorielle

Pour la fonction factorielle, il est possible de définir un deuxième cas de base : celui ou 𝑛 = 1 :

1.1.3. Cas récursifs/cas non-triviaux mutiples - Exemple avec la suite de syracuse

Remarque : Ici, il n'y a toujours qu'un seul appel récursif à la fois mais qui dépend du contexte. Cela diffère de la récursion multiple que nous allons voir par la suite.

La suite de Syracuse d'un nombre entier 𝑁 > 0 est définie par récurrence de la manière suivante :

- Quel que soit la valeur de départ 𝑁, la suite finit toujours par atteindre 1 (conjecture non prouvée mathématiquement actuellement - 1 millions de $ pour celui qui en porte la preuve).

- Le nombre d'étape pour atteindre la valeur 1 est appelée le temps de vol.

- La plus grande valeur de la suite obtenue est appelée l'altitude maximale.

- Implémenter en python la fonction

syracuse(n)qui renvoie la liste des valeurs de la suite de syracuse allant denà1en utilisant une bouclewhile. - Implémenter la version récursive :

syra_recursif(n) - Améliorer la fonction pour qu'elle donne également le temps de vol et l'altitude maximale.

1.2. Récursion double - Exemple de la suite de Fibonacci

On parle de récursion double quand le cas récursif fait deux fois appel à la fonction. L'exemple le plus connu est la suite de Fibonacci. Sa définition récursive est :

fibo(n) permettant

de calculer le n-ième terme de la suite de Fibonacci.

Récursion mutuelle (ou croisée)

Il s'agit de deux fonctions qui s'appellent mutuellement, c'est-à-dire que la première appelle la deuxième et la deuxième, la première.

pair et

impair mutuellement récursives, sans utiliser le modulo

% ni le not, telles que, étant donné un entier

n ≥ 0 :

-

pair(n)retourneTruesi n est pair etFalsesinon. -

impair(n)retourneTruesi n est impair etFalsesinon.

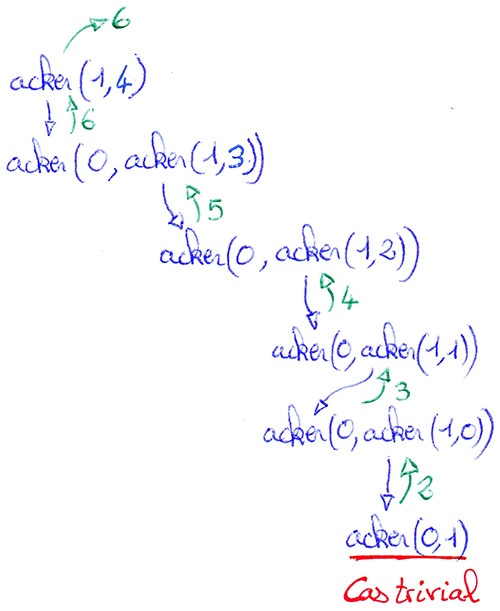

1.4. Récursion imbriquée - Exemple avec la fonction d'Ackermann

Un appel récursif est dit imbriqué quand il apparaît en tant qu'argument d'un appel récursif.

La fonction d'Ackermann est définie mathématiquement par :

La seule opération effectuée lors du déroulement de la fonction d'Ackermann est l'ajout de 1 (lorsque 𝑚 est nul). Malgré cela, cette fonction croît extrêmement rapidement : acker(4, 2) a déjà 19 729 chiffres ce qui représente bien plus que le nombre d'atomes estimé dans l'univers.

La fonction d'Ackermann est utilisée comme programme de test d'une implémentation d'un langage de programmation car elle utilise de façon très exigeante la récursivité.

Cliquer pour stopper l'animation.

(Image cliquable)

- Dessiner la pile d'exécution de l'appel acker(1,4).

-

Qualifier chaque cas de la fonction d'Ackermann (cas trivial, récursif simple, double, mutuel ou imbriqué) :

- quand 𝑚=0

- quand 𝑚>0 et 𝑛=0

- quand 𝑚>0 et 𝑛>0

Complexité d'un algorithme récursif

Un programme récursif a une complexité linéaire 𝑂(𝑛) dans le cas ou sa

pile d'exécution est linéaire. C'est le cas de la fonction factorielle où

le nombre d'appels récursifs est proportionnel à la taille du problème

qui est ici le nombre dont on veut calculer la factorielle.

Dans le cas de la suite de Fibonacci, la pile d'exécution n'est pas

linéaire car on a affaire à une récursion double. Chaque appel entraine un

double appel récursif ce qui conduit rapidement à une explosion des appels

de la fonction. La complexité est alors exponentielle 𝑂(2𝑛) . Ici la

taille du problème de rang 𝑛 correspond au rang de la suite que l'on

souhaite atteindre. Nous verrons par la suite que la

programmation dynamique permet d'optimiser l'algorithme

pour le rendre plus efficace.

La récursivité ne permet pas toujours d'apporter une meilleure réponse au

problème. Dans le cas de la suite de Fibonacci, il est possible d'obtenir

une complexité en 𝑂(𝑛) par simple itération (avec une boucle

while).

Pour comparer deux algorithmes, une bonne méthode est de les soumettre à un même problème (même taille) et de chronométrer leur temps de réponse. Ce temps de calcul est proportionnel au nombre d'opérations effectuées ce qui est une bonne représentation de la complexité relative d'algorithmes.

-

Implémenter la fonction itérative

fibo_it(n)(avec une bouclewhilequi renvoie le n-ième terme de la suite de Fibonacci. - Comparer le temps d'exécution des algorithmes itératif et récursif de la suite de Fibonacci.

Correction d'un algorithme récursif

Deux propriétés doivent être vérifiées pour s'assurer qu'un algorithme récursif fonctionne correctement :

- sa terminaison : est-ce qu'il se termine ?

-

sa correction partielle : fait-il ce qu'il est censé faire ?

Dans le cadre d'un algorithme récursif, si les appels récursifs font ce que l'on attend d'eux, alors l'algorithme tout entier fera ce qu'il est censé faire.

Cela ressemble au raisonnement par récurrence vu en mathématiques.

Exemple : Dans le cas de la fonction factorielle, sa

terminaison est assurée car la fonction prend en argument un entier

positif, l'appel récursif prend en argument l'entier décrémenté de 1 et le

cas d'arrêt est défini quand l'argument devient nul.

Sa correction

partielle consiste à s'assurer qu'un appel récursif renvoie bien :

𝑛 × 𝑓𝑎𝑐𝑡(𝑛-1)

Limitation de l'interpréteur python

-

Par défaut, python limite le nombre d'appels récursifs d'une fonction à

1 000. Au-delà, l'interpréteur python lève l'exception

RecursionErroret affiche le message :Recursion Error: maximum recursion depth exceeded. -

Pour augmenter cette limite, il faut utiliser la fonction

setrecursionlimit(5000)du modulesys. Cette solution sera de courte durée face à la limite de puissance du processeur et au temps d'exécution, en particulier avec des algorithmes de complexité exponentielle.

import sys

sys.setrecursionlimit(5000)

Des langages utilisant le paradigme fonctionnel sont plus adaptés à

l'utilisation de la récursivité. En effet, pour certains cas, ils sont

capables d'éviter de multiplier les environnements d'appels dans la pile

des appels récursifs.

Exemple :

Langage OCaml

Méthode "Diviser pour régner"

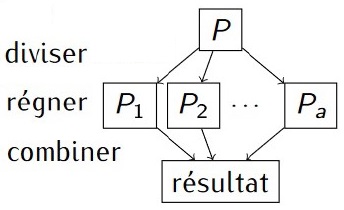

La méthode "Diviser pour régner" est composées de trois phases :

- la division : le problème initial est divisé en sous-problèmes de tailles inférieures.

- le règne : chaque sous-problème est résolu soit récursivement, soit directement s'il sont élémentaires.

- la combinaison : les solutions des sous-problèmes sont combinées pour obtenir la solution du problème initial.

- 𝑃 est un problème de taille 𝑛.

- 𝑃1, 𝑃2, ... , 𝑃𝑎 sont des problèmes de taille 𝑛/𝑎.

- Approche récursive : chaque 𝑃𝑖 est à son tour décomposé.

La récursivité est tout à fait adaptée à la méthode "Diviser pour Régner" du fait qu'elle divise un problème initial en sous-problèmes.

2.1. Application avec le tri fusion

On peut alors considérer ce sous-paquet comme étant trié et il ne reste plus qu'à fusionner tous les sous-paquets deux à deux pour reconstituer le paquet initial trié.

Résumons pour en déduire l'algorithme :

- s'il n'y a qu'une valeur dans la liste, celle-ci est forcément triée

- sinon, il faut couper la liste en deux, trier récursivement les deux sous-listes puis les fusionner.

Pseudo code : L'algorithme du tri fusion.

FONCTION tri_fusion(liste):

liste est la liste à trier

N ← longueur de la liste

Si N est nul ou vaut 1 alors retourner la liste telle quelle.

Sinon :

M ← Entier(N/2)

liste1 ← liste des M premiers éléments de liste

liste2 ← les éléments restant de la liste

Renvoyer la fusion de tri_fusion(liste1) et tri_fusion(liste2)

Cliquer pour stopper l'animation.

(Image cliquable)

-

Écrire une fonction

fusionqui à partir de deux listes triées, les fusionne pour obtenir une seule liste triée. - Écrire la fonction

tri_fusionqui implémente le pseudo-code présenté ci-dessus.

- Les algorithmes de tri simple tels que le tri à bulle

(par propagation), tri par insertion et tri par sélection nécessitent de parcourir tout ou partie de

la liste pour chaque élément de la liste.

Cela qui conduit à une complexité quadratique 𝑂(𝑛2) . - Le tri fusion est plus efficace. Sa complexité est linéarithmique : 𝑂(𝑛 log(𝑛)) .

2.2. Application avec la rotation de 90° d'une image bitmap

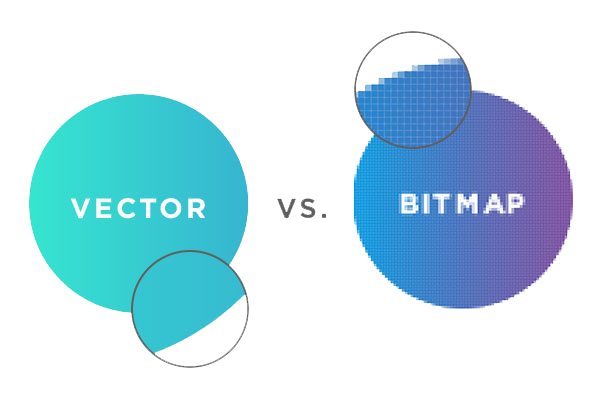

2.2.1. Image bitmap

Les images bitmap (aussi appelées images raster) sont des images consituées de pixels, c'est-à-dire d'un ensemble de points structurés dans un tableau. Chacun de ces points possède une ou plusieurs valeurs décrivant sa couleur.

Les images vectorielles sont constituées d'entités géométriques telles qu'un cercle, un rectangle, un segment... Ceux-ci sont représentés par des formules mathématiques (un rectangle est défini par deux points, un cercle par un centre et un rayon, une courbe par une équation, ...).

Une image vectorielle sera toujours nette quelle que soit sa taille contrairement à une image bitmap qui finira par se pixeliser.

Module PIL (ou pillow) de python

Pour manipuler une image en python, la bibliothèque PIL est parfaitement

adaptée. Elle prend en charge une trentaine de formats d'image bitmap.

from PIL import Image

Voici quelques objets et méthodes utiles de la bibliothèque PIL pour

réaliser l'exercice. La documentation complète est accessible sur :

Pillow (PIL Fork).

img = Image.open("mon-image.jpg") # Crée un objet img à partir d'un fichier

img.show() # Affiche l'image

img.save('mon-image-v2.jpg', 'jpeg') # Sauvegarde une copie de l'image au format JPEG

largeur, hauteur = img.size # Extrait la largeur et la hauteur en pixel

pix = img.load() # Charge la matrice de pixel

-

Les variables

imgetpixsont des instances d'objets définies dans la bibliothèquePIL. Il s'agit, respectivement :- d'un objet image, disposant de nombreuses méthodes (voir documentation), et

-

d'une matrice contenant tous les pixels de l'image, obtenue grâce à la

méthode

load()appliquée à notre objet image.

- Il est

possible depuis la matrice d'accéder à un pixel de l'image grâce à

-

l'instruction

pix[x, y]oùxetysont les coordonnées du pixel tel quex in range(largeur)ety in range(hauteur). Le pixel de coordonnées(0, 0)est situé en haut à gauche. - Un pixel est un tuple de trois entiers de 0 à 255 et correspondant respectivement à la composante rouge, verte et bleue du pixel ( formé de fait, de trois sous-pixel).

-

l'instruction

Application

L'objectif de cet exercice est de programmer la rotation d'une image d'un quart de tour avec une fonction récursive. Cette méthode permet d'avoir un coût en mémoire constant en modifier l'image sur elle-même. Pour simplifier le problème, on considère une image carrée dont la largeur en pixel est une puissance de 2.

L'idée est de diviser l'image en quatre carrés toujours plus petits jusqu'à atteindre un pixel puis de déplacer ces carrés pour effectuer la rotation.

|

|

|

en vidéo (Youtube) |

- Définir la fonction privée

_rotation(pix, x, y, n)qui réalise la rotation de la portion de l'image comprise entre les pixels de coordonnées(x, y)et(x+n, y+n).

Pour simplifier le problème, on considère une image carrée dont la largeur en pixel est une puissance de 2. - Définir la fonction

rotation(img)qui réalise la rotation à 90° de l'image en prenant comme argument l'objetimg.

Programmation dynamique

Le contexte

La programmation dynamique apparaît comme pratique de résolution de problèmes mathématico-logistiques et de planification dans les années fin 40 - début 50 du XXème siècle ; plus précisément, elle est formalisée par Richard Bellman entre 1950 et 1953 : l'adjectif «dynamique» a été choisi pour décrire les aspects suivants :

- plusieurs étapes

- dépendance du temps

Bellman a témoigné l'avoir choisi, en plus du côté descriptif d'actions spécifiques dans le temps, pour son aspect vendeur, lui servant de «parapluie pour ses activités» ; activités fort utiles et fécondes. C'est un exemple historique de «coup marketing» qu'un chercheur a été contraint d'employer pour mener d'autres activités qui s'avèrent indispensables aujourd'hui.

Description de la méthode - Exemple avec la suite de Fibonacci

La méthode diviser pour régner scinde un problème en sous-problèmes, souvent indépendants, qu'on résout récursivement, puis la combinaison des solutions obtenues permet de résoudre le problème initial. Cependant, elle perd grandement en efficacité lorsqu'on résout plusieurs fois le même sous-problème.

print permettant

d'obtenir l'historique des appels de cette même fonction. Tester pour

𝑛 = 5 et 𝑛 = 50.

Si l'on représente les appels récursifs de l'appel fibo(5) comme un

graphe, on obtient le graphe suivant :

La programmation dynamique consiste alors à

stocker les valeurs des sous-problèmes, dans un tableau, pour éviter

les recalculs (on parle parfois de «cache» ou de mémoïsation).

Selon la direction dans laquelle on lit le graphe, on a deux méthodes

dont voici les algorithmes :

- Méthode ascendante (bottom-top)

des plus petits problèmes vers les plus grandsfonction fibonacci(n) F[0] = 0 F[1] = 1 pour tout i de 2 à n F[i] = F[i-1] + F[i-2] retourner F[n] -

Méthode descendante (top-bottom)

des plus grand problèmes vers les plus petitsfonction fibonacci(n) si F[n] n'est pas défini si n = 0 ou n = 1 F[n] = n sinon F[n] = fibonacci(n-1) + fibonacci(n-2) retourner F[n]

- Implémenter ces deux approches en python et comparer leur efficacité.

- Comparer la complexité des trois solutions ; pour l'implémentation,

on pourra utiliser :

import time start = time.time() # choses à faire end = time.time() print("DURÉE = "+str(end-start)+" s")

-

les résultats intermédiaires peuvent être stockés dans une liste

(par exemple

res) ; pour modifier cette liste depuis une fonction, il faut la déclarer variable globale dans la fonction avec :global res. -

Noneetis Nonepermettent de modéliser et de tester des emplacements «vides» dans les listes.

Distance de Levenshtein

Deux chaines de caractères, st1 et st2 étant

données, la distance de Levenshtein, aussi nommée

distance d'édition, est le nombre minimal de modifications, chacune d'un

seul caractère, permettant de transformer st1 en

st2. Par modification d'un seul caractère, on entend :

- Remplacer un caractère par un autre ;

- Insérer un caractère ;

- Effacer un caractère.

Voir la vidéo de Graphikart : Distance de Levenshtein.

On peut calculer la distance de Levenstein de la manière suivante :

def lev(st1, st2) :

if not st1: # si st1 est vide

return len(st2)

elif not st2: # si st2 est vide

return len(st1)

else :

subst = int( st1[-1] != st2[-1] )

# subst vaut 1 si les derniers caractères de st1 et st2 sont

# différents, et vaut 0 si ce sont les mêmes.

return min([lev(st1[:-1], st2 ) + 1, # insertion d'un char st1 -> st2

lev(st1 , st2[:-1]) + 1, # suppression d'un char st1 -> st2

lev(st1[:-1], st2[:-1]) + subst]) # remplacement ou non d'un char st1 -> st2-

Tester cet algorithme pour des cas simples : "Bonjour" et "Bonsoir",

"buse" et "écluse".

Qu'observe-t-on ? - Quelle est la complexité de cet algorithme ?

Pour dynamiser cet algorithme, on va utiliser le fait que

lev(st1,st2) == lev(st1.reverse(),st2.reverse()) : en effet,

en inversant l'ordre (sans les mélanger) des deux chaînes, on obtient la

même distance ; en alliant ce fait à une logique de programmation

dynamique bottom-top, on organise les calculs selon un tableau à double

entrée (st1 sur les lignes et st2 pour les

colonnes) :

| ∅ | m | a | i | r | e | |

| ∅ | ||||||

| m | ||||||

| è | 𝑎 | 𝑏 | ||||

| r | 𝑐 | 𝑥 | ||||

| e |

- Expliquer comment remplir la ligne et la colonne en face des chaînes vides (symbolisées par ∅).

- En lisant l'algorithme précédent, expliquer comment déterminer 𝑥 à partir de 𝑎, 𝑏 et 𝑐 ; remarque : 𝑥 pourrait occuper n'importe quelle case non encore remplie dans le tableau.

- Remplir le tableau à la main.

- Où apparaît la distance de Levenshtein dans le tableau ?

Problème du rendu de monnaie

L'objectif est, à partir d'un système de monnaie, de trouver comment

rendre une somme de façon optimale, c'est-à-dire avec le moins de

pièces et de billets possible. Le système de monnaie européen est :

[0.01, 0.02, 0.05, 0.10, 0.20, 0.50, 1, 2, 5, 10, 20, 50, 100, 200, 500]

Rappel : En 1ère nous avons vu la stratégie gloutonne pour résoudre ce problème. L'idée de cet algorithme était assez intuitive et consiste, à chaque étape, à faire le choix qui semble le plus optimal. C'est-à-dire, pour le problème du rendu de monnaie, de toujours choisir la plus grande valeur possible pour atteindre la valeur souhaitée. Cette stratégie est effectivement optimale quand le système de monnaie l'est aussi. C'est le cas de la monnaie européenne mais pour d'autre système de monnaie, l'algorithme glouton n'est plus optimal.

-

Montrer qu'avec le système

[1, 3, 4], l'algorithme glouton ne donne pas le résultat optimal. On pourra essayer de rendre la monnaie sur une somme de 6. - On veut rendre la monnaie sur une somme de 6. Dessiner un arbre dont la racine est 6, dont chaque nœud a 3 fils correspondant à l'action de rendre 1, 3 et 4 sur la somme indiquée dans le nœud considéré.

- Implémenter en Python un algorithme récursif de rendu de monnaie donnant le nombre de pièces minimal si le rendu est possible (l'algorithme doit juste donner le nombre de pièces et pas la décomposition de la somme ; cette dernière option est réalisable, mais encore plus technique).

- Tester ce programme récursif. Est-il efficace ? Pourquoi ?

Pour le rendre plus dynamique, on va stocker les résultats obtenus dans un

tableau de taille somme+1 (de 0 à somme).

Recherche textuelle

La recherche d'une sous-chaîne de caractères dans une plus grande chaîne de caractère est un grand classique en algorithmique. Ces algorithmes sont natommant utilisés en bioinformatique à propos de la recherche de séquence ADN. L'ADN est une molécule en double hélices qui est constituée d'un enchaînement de quatre nucléotides différents : A, C, G et T pour Adénine, Cytosine, Guanine et Thymine. Cette suite de nucléotides code l'information pour la synthèse des protéines essentielles au fonctionnement de notre organisme. Le séquençage de l'ADN à l'origine de la révolution de la recherche en génétique, consiste à obtenir la suite des nucléotides et à y rechercher des motifs correspondant à différents gènes. L'optimisation des algorithmes de recherche est un enjeu majeur pour la recherche génétique.

- La chaîne de caractère recherchée est appelée le motif ou la clé.

- La chaîne de caractère dans laquelle s'effectue la recherche est appelée la séquence ou le texte.

- Chaque apparition du motif dans le texte est appelée une occurrence.

Algorithme naïf (Algorithme par force brute)

L'approche naïve pour la recherche textuelle est d'effectuer une comparaison du motif avec la séquence en commençant par la gauche et en comparant les caractères un par un de gauche à droite puis en décalant le motif vers la droite caractère par caractère. On parle ici de force brute car nous testons ainsi toutes les possibilités, ce qui est la caractéristique des algorithmes par force brute.

- Implémenter l'algorithme naïf de recherche textuelle qui renvoie l'indice de la première occurrence.

- Compléter l'algorithme précédent pour qu'il renvoie l'indice de toutes les occurrences dans une liste.

- Quelle est la complexité de cet algorithme naïf ?

Algorithme de Boyer-Moore

L'algorithme de Boyer-Moore, optimise l'algorithme naïf en diminuant le nombre de comparaisons par l'élimination de celles qui sont inutiles.

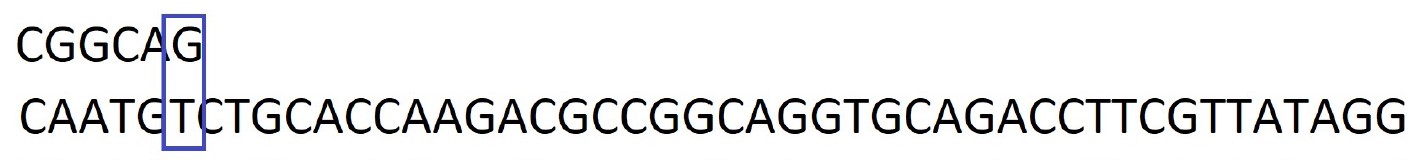

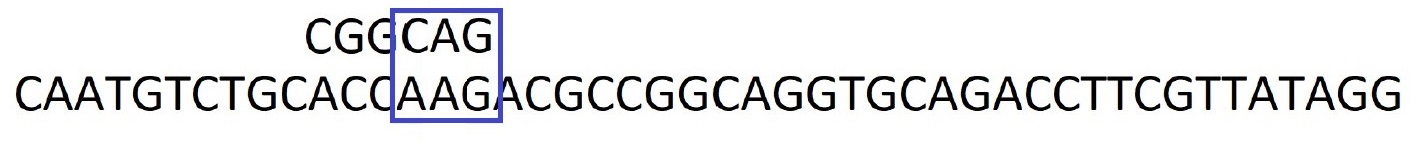

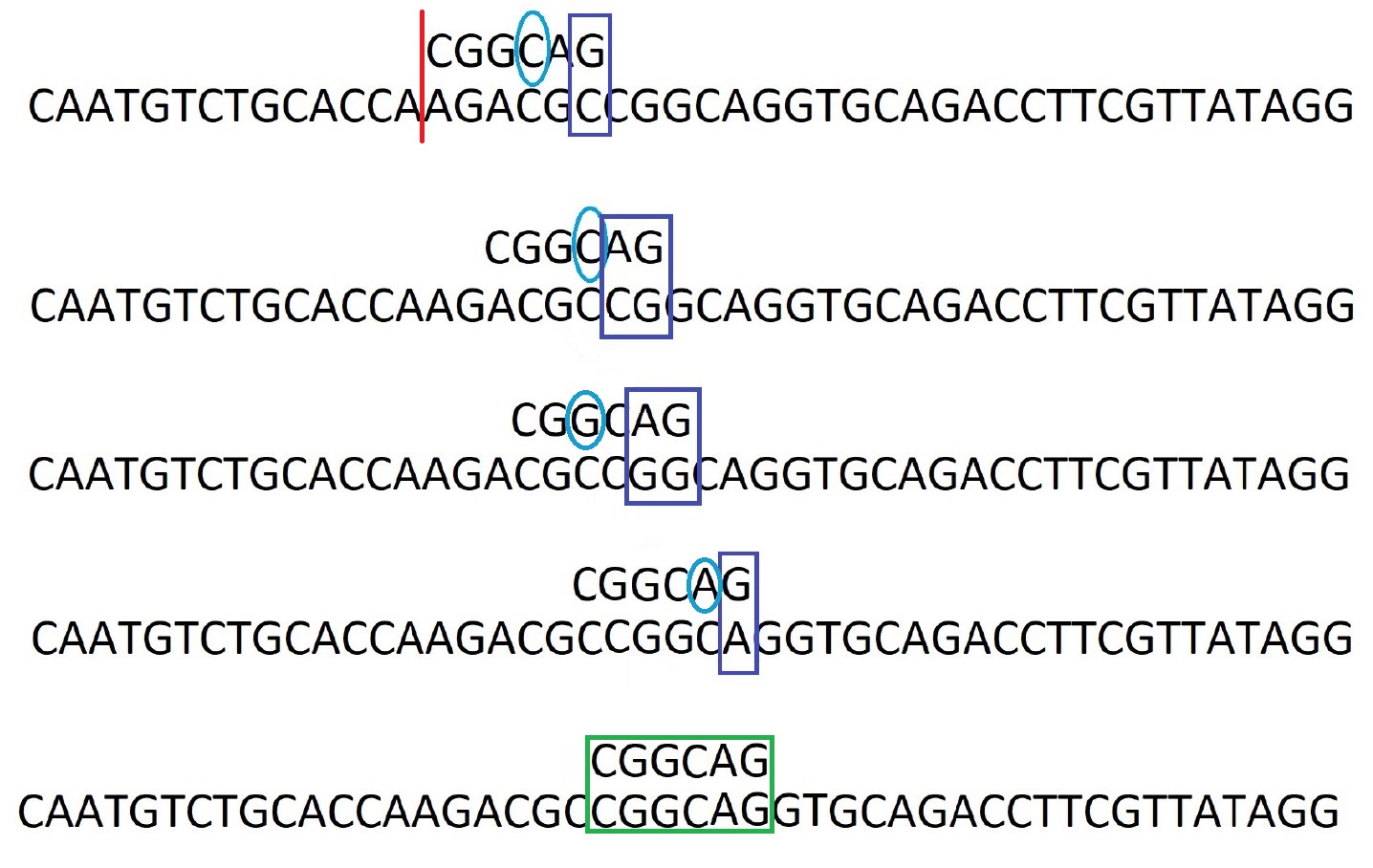

Considérons le motif : CGGCAG à rechercher dans

la

séquence : CAATGTCTGCACCAAGACGCCGGCAGGTGCAGACCTTCGTTATAGG

Etape 1 : On commence à placer le motif sur la gauche de la séquence.

Première idée de l'algorithme de Boyer-Moore : Comparer le motif à

la séquence en partant de la droite.

Deuxième idée : Sachant que le

motif ne contient pas la lettre T, il est possible de

décaler tout le motif pour le placer après la lettre T de

la séquence.

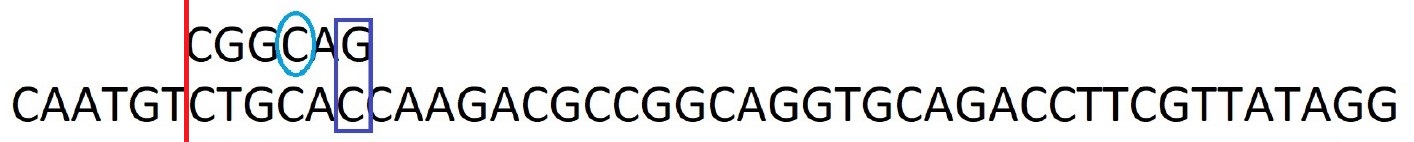

Etape 2 : On recommence les comparaisons par la droite. Troisième idée : Le caractère C ne correspond pas il est ailleurs dans le motif. On décale le motif jusqu'à faire correspondre le caractère C.

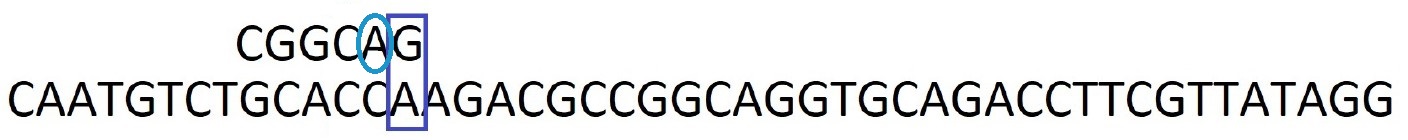

Etape 3 : On recommence les comparaisons par la droite. Encore une fois, le caractère A ne correspond pas mais il est ailleurs dans le motif. On décale le motif pour faire correspondre le caractère A.

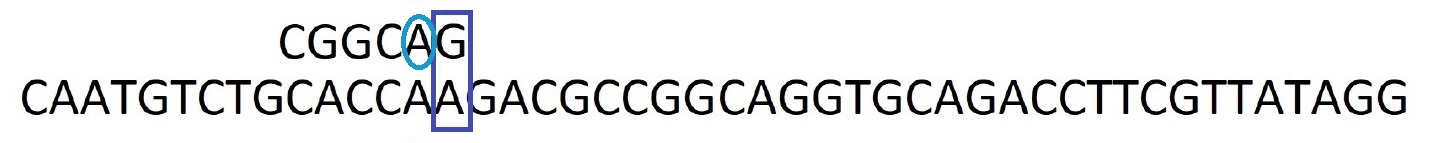

Etape 4 : On recommence les comparaisons par la droite. Encore une fois, le caractère A ne correspond pas mais il est ailleurs dans le motif. On décale le motif pour faire correspondre le caractère A.

Etape 5 : On recommence les comparaisons par la droite. Les caractères G et A correspondent mais pas le caractère A suivant. Sachant qu'il n'y a plus de A dans le motif, on peut le décaler au delà de ce caractère A de la séquence.

Etape 6 : Et ainsi de suite jusqu'à trouver une occurrence. On note alors sa position dans la séquence.

Etape 7 : Après avoir trouver une occurrence, on regarde le caractère suivant dans la séquence, ici c'est un G. Sachant qu'il y a un G dans le motif, on décale le motif pour les faire correspondre.

Etape 8 : Et on recommence les comparaisons par la droite ...

Les trois grandes idées de l'algorithme de Boyer-Moore sont donc :

- La comparaison de droite à gauche des caractères du motif et du texte.

- Le décalage du motif de plusieurs crans vers la droite lorsque c'est possible plutôt que de le faire glisser d'un seul caractère à la fois.

- Le pré-traitement du motif afin d'en avoir une bonne connaissance et permettre les grands décalages du motif.

À travers l'exemple précédent, on voit qu'il faut connaître le motif pour

effectuer des sauts et faire correspondre une lettre de la séquence à sa

première occurrence en suivant dans le motif.

Une première étape importante

dans l'algorithme sera alors de créer une

table de décalage.

Cette dernière doit nous dire combien

de sauts effectuer dans le cas ou un caractère ne correspondrait pas. Il

s'agit d'une table à double entrées : le caractère recherché et la

position du caractère du motif qui diffère de la séquence.

|

Position dans le motif du caractère qui diffère |

Nombre de sauts pour atteindre : | ||

| un A | un C | un G | |

| 0 | 0 | ||

| 1 | 1 | 0 | |

| 2 | 2 | 0 | |

| 3 | 0 | 1 | |

| 4 | 0 | 1 | 2 |

| 5 | 1 | 2 | 0 |

Aide :

- La table de décalage peut être implémentée par une liste de

dictionnaires. Un dictionnaire par ligne de la table de décalage et

faisant correspondre la lettre recherchée au nombre de sauts à

effectuer.

Implémenter la fonctiontable_decalagepermettant de générer cette table à partir du motif. - Reste ensuite à coder l'algorithme de recherche du motif dans le texte en faisant appel à la table de décalage quand un caractère diffère. Il faudra traiter le cas où le caractère recherché n'existe plus dans le reste du motif et alors réaliser un décalage jusqu'à la fin du motif.

time de python.

Pour aller plus loin : Algorithme KMP

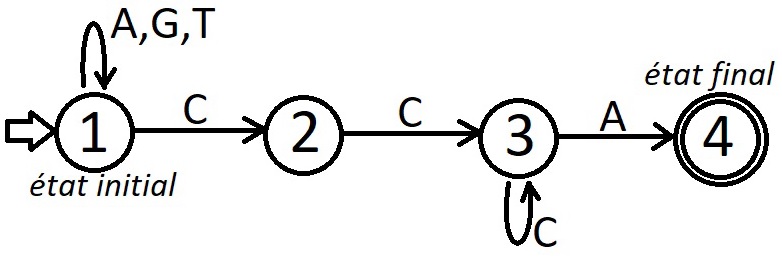

Pour approfondir ce domaine de l'algorithmique de recherche textuelle, sachez que l'outil «principal» est l'automate. Grossièrement, un automate est un graphe orienté dont les arêtes ont été étiquetées :

Si vous êtes intéressé, vous pouvez rechercher l'algorithme de Knuth-Morris-Pratt, qui est un autre algorithme de recherche d'un motif dans un texte. Il existe en deux versions, une version où la présence des automates est masquée pour permettre une compréhension de l'algorithme au plus grand nombre, y compris à ceux qui n'ont jamais entendu parler d'automates, et une deuxième version dans laquelle les automates sont présents. Tapez "Algorithme de Knuth-Morris-Pratt" ou "Automate des occurrences" dans votre moteur de recherche préféré pour trouver ces deux versions.

| en français | en anglais |

|---|---|

| récursivité | recursion |

| fonction factorielle | factorial function |

| algorithme diviser pour régner | divide-and-conquer algorithm |

| tri fusion | merge sort |

| programmation dynamique | dynamic programming |